为了协助人类进行日常活动并成功完成家务,机器人应该能够有效地操纵我们每天使用的物体,包括器具和清洁设备。然而,由于某些物体的形状、灵活性或其他特性,机器人手难以抓住和处理某些物体。

这些物品包括纺织布,人类通常用它们来清洁表面、擦亮窗户、玻璃或镜子,甚至拖地板。这些都是机器人可能完成的任务,但在此之前,机器人需要能够抓取和操纵衣服。

苏黎世联邦理工学院的研究人员最近引入了一种新的计算技术来创建皱巴巴的衣服的视觉表示,这反过来又可以帮助规划机器人在完成任务时抓住衣服并使用它们的有效策略。这项技术是在arXiv上预先发表的一篇论文中介绍的,被发现可以很好地推广到具有不同物理特性、不同形状、尺寸和材料的布料。

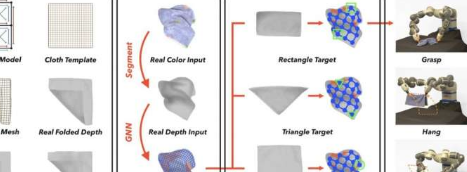

WenboWang、GenLi、MiguelZamora和StelianCoros在他们的论文中写道:“由于布料模型的高维性以及对自遮挡区域的观察有限,精确重建和操纵一件皱巴巴的布料具有挑战性。”“我们利用单视图人体重建领域的最新进展,通过我们提出的模拟真实配准协议,仅从顶视图深度观察中基于模板重建皱巴巴的衣服。”

为了重建皱巴巴的衣服的整个网格,Wang、Li和他们的同事使用了基于图神经网络(GNN)的模型。这些是一类算法,旨在处理可以表示为图形的数据。

为了训练他们的模型,研究人员编制了一个数据集,其中包含120,000多张来自布料网格模拟的合成图像和渲染的顶级视频RGBD布料图像,以及3,000多张在现实环境中捕获的带标签的布料图像。经过对这两个数据集的大量训练后,发现团队的模型只需从上方查看布料即可有效预测整个布料顶点的位置和可见性。

Wang、Li和他们的同事写道:“与之前的隐式布料表示相比,我们的重建网格明确地指示了整个布料网格顶点的位置和可见性,从而实现了更有效的双臂和单臂目标导向操作。”

为了评估模型的性能,研究人员在模拟和实验环境中进行了一系列测试。在这些测试中,他们将模型应用于ABBYuMi机器人,这是一个具有两只手臂和一只手的人形半身机器人。

在模拟和实验中,他们的模型能够生成布料的网格表示,可以有效地引导ABBYuMi机器人的运动。这些网格使机器人能够更好地握住和操纵各种布料,无论是单手还是双手。

研究人员写道:“实验表明,我们基于模板的重建和目标导向操纵(TRTM)系统可以应用于与我们的模板网格拓扑相似的日常服装,但具有不同的形状、尺寸、图案和物理特性。”

研究人员编译的数据集及其模型代码是开源的,可以在GitHub上访问。未来,这项最新工作可能为机器人领域的进一步发展铺平道路。最值得注意的是,它可以帮助提高移动机器人设计的能力,以协助人类做家务,提高这些机器人处理桌布和各种其他常用清洁布的能力。